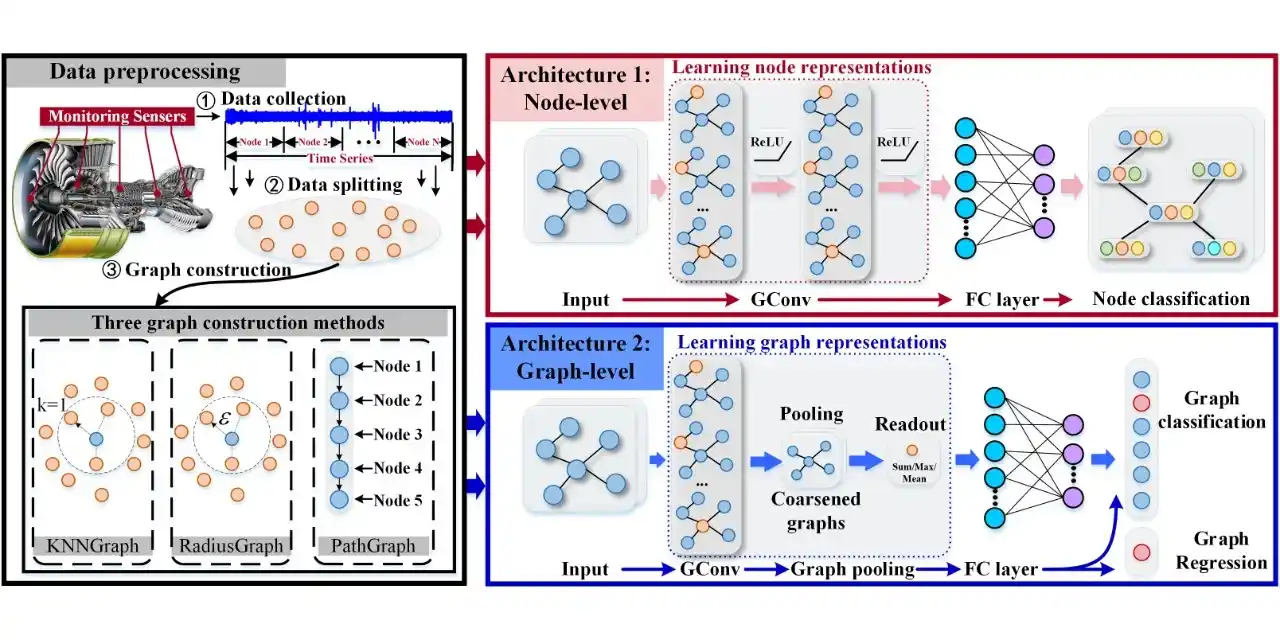

你的模型在“作弊”吗?深度解析机器学习中“数据泄露”的隐蔽陷阱

前言

本文将探讨在日常机器学习应用过程中可能出现的数据泄露问题。这个问题在业界通常被称为 “目标泄露”(Target Leakage) 或 “数据窥探”(Data Snooping)。这一问题在相关机器学习教程中鲜有专门讨论,甚至许多从事交叉学科研究的初学人员也未必了解。掌握这一点后,读者将能够更容易地识别出部分论文中存在的错误,或那些对相关细节缺乏严谨说明的情况。

2023 年的一项研究发现,数据泄露是“基于机器学习 的科学中普遍存在的失败模式”,影响了 17 个学科的至少 294 篇学术出版物,并导致了潜在的可重复性危机。

我个人认为目前这个情况是保守了(苦笑

什么是数据泄露

数据泄露的核心定义是在模型训练过程中使用了在预测时不应获得的信息 。这种”额外信息”可能来自未来数据、测试集、目标变量本身或全局统计量。这是一种程序性错误,模型通过获取未来或特权信息来有效地“作弊” 。这种现象一般是微妙且间接的,很多机器学习使用者有可能会忽略的存在。

从信息论角度看,数据泄露创造了一种”时空穿越”效应——模型在训练时获得了本不应在预测时点存在的知识。这导致模型的学习目标发生偏离:它不再学习数据的内在规律,而是记忆了特定的数据特征或利用了不当的捷径。最终结果是训练阶段的性能指标严重高估,而部署后的实际表现一落千丈。

上面的描述可能有点难以理解,我用人话举个例子:

可以将其类比为一名学生带着答案来备考。这位学生可能会在模拟测试(验证集)中取得完美的分数,但在没有答案的真实考试(生产环境)中却会失败 。这个例子就清晰地揭示了问题的本质:模型并非在学习如何泛化规律,而是在学习如何识别泄露的答案。

数据泄露形式

数据泄露形式主要有两种:目标泄露和训练-测试污染。

目标泄露:用未来知识预测现在

目标泄露(Target Leakage)的定义是,训练数据中的预测变量包含了在目标值实现之后才被更新或创建的信息。本质上,这个特征是目标本身的代理,但在实际预测时,这些信息是不可用的 。

其机制在于,模型学习到的是一种虚假的、非因果的关系。它没有学习到预测结果的潜在模式,而是学习到了结果本身存在于特征中的这一“人造信号”。

典型案例:

- 医疗诊断:在预测是否患有肺炎(

got_pneumonia)时,使用了一个特征took_antibiotic_medicine(是否服用抗生素)。由于抗生素是在诊断之后才开具的,这个特征泄露了最终的结果 。 - 贷款偿还:在预测客户是否会偿还贷款时,使用了一个特征如

repayment_status(还款状态)。这个状态只有在还款期结束后才能确定,因此泄露了目标 。 - 信用卡申请:在预测信用卡申请是否会被批准(

approved)时,使用了一个特征expenditure(新卡支出)。支出只有在申请被批准之后才可能发生 。 - 员工离职:在预测员工是否会离职时,使用了一个特征如

retention_bonus_offered(是否提供了留任奖金)。这笔奖金通常是在员工表露出离职意向后才提供的,从而泄露了关于结果的信息 。

训练-测试污染:破坏评估过程

训练-测试污染(Train-Test Contamination)是另一种形式的泄露。它发生在来自验证集或测试集的信息无意中渗入到训练过程中,从而破坏了评估的完整性。模型实际上已经“看到”了测试数据,使其在该数据集上的表现被人为地拔高,因此无法作为泛化能力的可靠衡量标准。

大部分你能在论文中看到的可能出现的问题就在这里

这种泄露的机制几乎总是源于在将数据集分割为训练集和测试集之前,对整个数据集应用了数据转换或拟合了预处理步骤 。

典型案例:

- 数据缩放/归一化:在整个数据集上计算均值/标准差(用于

StandardScaler)或最小值/最大值(用于MinMaxScaler)。这使得测试集的统计特性影响了训练集的转换过程 。 - 缺失值插补:通过计算整个数据集的均值、中位数或众数来填充缺失值。这使得模型利用了测试集的分布信息来填补训练集中的空白 。

- 特征选择:在整个数据集上执行特征选择(例如,基于方差或相关性)。模型可能会选择那些仅因为测试集中存在的模式而显得重要的特征。

- 重采样 (SMOTE/上采样):在分割数据之前应用技术来平衡不平衡的数据集。这可能导致来自测试集的少数类样本的相同副本或合成副本出现在训练集中 。

常见原因分类

预处理陷阱(训练-测试污染的主要来源)

- 分割前的缩放/归一化:在整个数据集上应用

StandardScaler、MinMaxScaler等。这些转换器的参数(均值、标准差、最小值、最大值)是从所有数据中学习的,从而将测试集的统计信息泄露到了训练集中 。 - 分割前的插补:从完整数据集中计算插补值(如中位数),并用它来填充训练集中的缺失值 。

- 分割前的重采样:在整个数据集上应用SMOTE或随机过采样。这可能导致相同或合成的样本同时出现在训练集和测试集中,从而保证了模型在那些“未见过”的样本上表现良好 。

- 分割前的目标编码:使用完整数据集计算基于目标的统计数据(例如,给定类别的目标均值)。这将测试集的目标变量信息直接泄露到训练集的特征中 。

有缺陷的特征工程(目标泄露的关键来源)

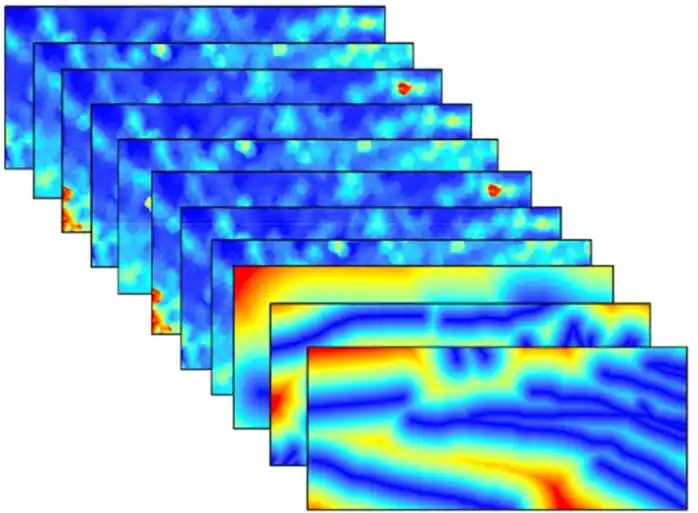

- 时间泄露(使用未来数据):这是时间序列问题中的一个严重错误。创建的特征使用了相对于预测点而言来自未来的信息。例如,在预测某笔交易时,使用该交易之后发生的交易来计算客户的平均交易金额 。

- 无意的代理变量:创建的特征是目标变量的结果。例如,

days_in_hospital(住院天数)可能是医院获得性感染的一个完美预测指标,但住院天数是在感染情况已知之后才确定的。 - 数据派生特征:如果数据是根据结果以非随机方式收集或排序的,那么像行号、文件创建时间戳或图像文件大小等特征有时可能成为目标的无意代理 。

不恰当的数据分割与验证

- 随机分割时间序列数据:在分割前对时间相关的数据进行洗牌,会破坏其时间顺序,使模型能够利用未来的数据来预测过去 。

- 忽略分组结构:在每个实体有多条记录的数据集(例如,每个病人的多张医学影像,每个客户的多笔交易)中,简单的随机分割可能会将来自同一实体的数据同时放入训练集和测试集。这导致模型学会了识别实体,而不是通用的模式 。这也被称为“分组泄露”。

- 不正确的交叉验证:在交叉验证循环之前执行预处理。这会用整个数据集的信息污染所有的折(folds)。预处理必须在每个折的训练分割内部完成 。

错误示例

以下 Python 代码示例展示了执行建模任务的错误方式(分割前缩放)和正确方式

1 | from sklearn.model_selection import train_test_split, cross_val_score |

下面的是正确的过程:

1 | from sklearn.pipeline import Pipeline |

与过拟合的区别

数据泄露与过拟合的关系密切但又有所区别。过拟合是模型过度学习训练数据的噪声和细节,导致在训练集上表现优异但在测试集上表现不佳。然而,数据泄露更为隐蔽和危险——它可以使模型在训练集和测试集上都表现出色,因为测试集的信息已经通过某种方式泄露到了训练过程中。这意味着传统的训练-测试分割方法无法检测出数据泄露,只有在真实的生产环境中才会暴露问题。

过拟合的典型症状是模型在训练集上表现优异,但在测试/验证集上的表现却显著下降 。这表明模型“记住”了训练数据,而不是学习到了其背后的潜在模式 。

从更深层次的角度看,数据泄露从根本上破坏了统计学习理论的基本假设。监督学习评估的核心前提是,测试集可以作为未见过的真实世界数据的无偏代理,并且我们假设训练数据和测试数据是独立同分布的。训练-测试污染直接违反了“独立性”假设,因为信息从测试集流向了训练集,使它们在统计上产生了依赖。目标泄露则违反了模型学习函数 $f(X) \rightarrow Y$ 的前提,模型实际上学习的是 $f(X, Y_{proxy}) \rightarrow Y$,这对于现实世界的预测是无用的,因为 $Y_{proxy}$ 是不可用的。因此,数据泄露不仅仅是产生了一个坏模型,它从根本上摧毁了我们赖以评估模型未来性能的整个框架。这正是它比过拟合更为隐蔽和危险的原因——过拟合是框架内部的失败,而数据泄露是框架本身的失败。

结语

这种方法论上的失败不仅仅是学术上的瑕疵,它已经成为机器学习科学中一种普遍存在的失败模式。这表明,许多已发表的高性能模型可能并不具备泛化能力,其宣称的优异结果可能只是错误方法的产物,而非真正的科学突破。这不仅动摇了机器学习作为一门实证科学的可信度,也凸显了在同行评审中,除了审查模型架构和结果外,更需要对数据处理协议进行严格审计的必要性。

科学探索永无止境,本文仅为笔者个人学习总结。因知识所限,文中若有不当之处,敬请方家斧正。

参考内容

- Kapoor, S., & Narayanan, A. (2023). Leakage and the reproducibility crisis in machine-learning-based science. Patterns, 4(9).

- Data Leakage: Risks, Causes, & Prevention

- Leakage (machine learning)

- Preventing data leakage in time-series data splitting

- How to prevent Data Leakage problem: Illustrated with Practical Examples